Meta mueve ficha en su carrera frente a Google, OpenAI / Microsoft y Anthropic.

El 18 de abril Meta ha presentado Llama 3, en sus palabras «la nueva generación de nuestro modelo de lenguaje a gran escala».

Un importante paso adelante, acompañado de varias novedades, entre ellas la apuesta por el open source y la disponibilidad web de los modelos Llama 3 (aún no en España, y aún no en español), ya no dependemos solo de su integración en apps como WhatsApp, Instagram, Facebook o Messenger. Además, pronto estarán disponibles en AWS, Databricks, Google Cloud, Hugging Face, Kaggle, IBM WatsonX, Microsoft Azure, NVIDIA NIM y Snowflake, y con soporte de plataformas de hardware ofrecidas por AMD, AWS, Dell, Intel, NVIDIA y Qualcomm.

En los próximos meses prometen introducir nuevas funciones, ventanas contextuales más largas, tamaños de plantilla adicionales y un rendimiento mejorado, además de compartir el documento de investigación sobre Llama 3. Así mismo desde Meta prometen que en breve será capaz de entender imágenes y vídeos además de texto.

¿Cómo probar Llama 3?

Lo vas a poder utilizar en formato web, desde Meta.ai, de hecho en un formato muy parecido a ChatGPT o Gemini.

Pero… (no todo van a ser buenas noticias), por el momento solo se puede usar Meta.ai si estamos en Estados Unidos o alguno de los 13 países adicionales que han sido incluidos en el lanzamiento inicial: Australia, Canada, Ghana, Jamaica, Malawi, Nueva Zelanda, Nigeria, Pakistán, Singapur, Sudáfrica, Uganda, Zambia, y Zimbabwe.

Mediante VPN sí podrás probar Meta, simulando que navegas desde uno de estos países. Eso sí, lo tendrás que hacer en inglés, de momento no está disponible en español, como antes indicábamos.

Desde bots.blog podemos afirmar que el comportamiento es ya muy avanzado, y ha mejorado, aunque sin llegar al nivel de GPT 4. Un punto muy a su favor es la velocidad de generación de la respuesta. Esperemos que también mejore en el uso por API, verdaderamente es un fallo relevante cuando empleamos GPT a través de API, los tiempos de espera dañan la dinámica conversacional de forma muy relevante (tengamos en cuenta que en el uso por API ni siquiera vamos viendo la generación progresiva de la respuesta como ocurre en el uso por web).

Costes

Se desconoce cuál será el coste del uso de Llama 3 a través de API. Hablan de Opensource pero en la explotación a través de plataformas como Google o AWS sin duda tendrá coste. La esperanza es que esta competencia tire de los costes hacia abajo, aún demasiado altos desde nuestro punto de vista en GPT.

Más seguridad

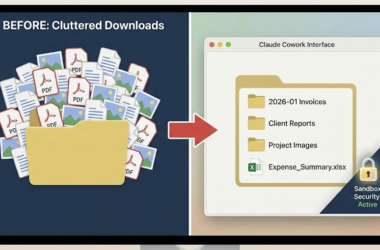

Meta ha incluido nuevos componentes para mejorar la seguridad: componentes actualizados con Llama Guard 2 y Cybersec Eval 2, y la introducción de Code Shield, una barrera en tiempo de inferencia para filtrar el código inseguro producido por los LLM.

El origen de las mejoras

Una de las claves en las mejoras de Llama 3 ha sido la expansión significativa de su conjunto de datos de entrenamiento: 15 trillones de tokens. Este volumen es aproximadamente siete veces mayor que el utilizado para los modelos Llama 2. Llama 3 utiliza un tokenizador con un vocabulario de 128.000 tokens que codifica el lenguaje de forma mucho más eficiente, lo que mejora sustancialmente el rendimiento del modelo. Para mejorar la eficacia de inferencia de los modelos de Llama 3, han adoptado la atención a consultas agrupadas (GQA) en los tamaños 8B y 70B. Entrenamos los modelos en secuencias de 8.192 tokens, utilizando una máscara para garantizar que la autoatención no cruce los límites del documento.

Expectantes

Así pues, grandes novedades, con limitaciones aún para el mercado español, pero que poco a poco irán llegando, revolucionando el entorno LLM y obligando a mover ficha a sus competidores.