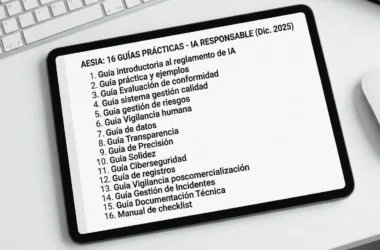

Un nuevo paradigma en la inteligencia artificial

La inteligencia artificial (IA) está en constante evolución, y una de las innovaciones más emocionantes de 2025 es el lanzamiento de DeepSeek V3.2-Exp, un modelo experimental que introduce el mecanismo de DeepSeek Sparse Attention (DSA). Esta tecnología promete transformar la forma en que los modelos de IA procesan grandes volúmenes de datos, ofreciendo una solución más eficiente y accesible. En este artículo, exploraremos cómo DeepSeek está redefiniendo el futuro de la IA con su enfoque en la atención dispersa, su estrategia de código abierto y su impacto en la democratización de esta tecnología.

DeepSeek y la carrera por la eficiencia en IA

Mientras que las grandes tecnológicas occidentales, como OpenAI, Anthropic y Google, han centrado sus esfuerzos en acumular poder computacional con centros de datos masivos, las compañías chinas, como DeepSeek, han adoptado un enfoque diferente. Restringidas por el acceso limitado a los procesadores más avanzados, estas empresas han innovado en metodologías matemáticas y arquitecturas más inteligentes. El resultado es un modelo como DeepSeek V3.2-Exp, que no solo compite en potencia con los gigantes de la industria, sino que lo hace con un coste significativamente menor.

Lanzado en enero de 2025, DeepSeek ya demostró su capacidad para superar a muchos modelos occidentales con un entrenamiento más eficiente. Ahora, con DeepSeek V3.2-Exp, la compañía da un paso más allá al introducir la atención dispersa, una técnica que aborda una de las mayores limitaciones de los modelos basados en transformadores: la complejidad cuadrática.

¿Qué es la atención dispersa y por qué importa?

El mecanismo de atención completa, descrito en el seminal artículo de 2017 «Attention is All You Need», es el núcleo de los modelos de transformadores modernos. Sin embargo, tiene un inconveniente significativo: para procesar una secuencia de datos, calcula la relación entre todos sus elementos, lo que resulta en una complejidad computacional de O(n²). Esto funciona bien para textos cortos, pero se vuelve prohibitivo en términos de recursos cuando se trata de contextos largos, como libros completos, bases de código extensas o documentos legales.

Aquí es donde entra en juego la atención dispersa de DeepSeek. En lugar de conectar todos los elementos de una secuencia entre sí, este enfoque selecciona un subconjunto estratégico de conexiones relevantes, reduciendo significativamente el coste computacional. Es como pasar de una conversación caótica en la que todos hablan con todos a un diálogo eficiente entre expertos seleccionados. Este cambio no solo mejora la eficiencia, sino que permite manejar contextos de decenas de miles de tokens de manera coherente, abriendo la puerta a aplicaciones antes impensables.

Arquitectura Mixture of Experts (MoE): El corazón de DeepSeek V3.2-Exp

El núcleo de DeepSeek V3.2-Exp es su arquitectura de Mixture of Experts (MoE). En lugar de depender de un modelo monolítico, DeepSeek utiliza un ecosistema de redes neuronales más pequeñas y especializadas, conocidas como «expertos». Estos expertos se activan de forma selectiva mediante un mecanismo de enrutamiento dinámico, lo que significa que solo una fracción del modelo se utiliza para procesar cada entrada. Esto permite que el modelo alcance cientos de miles de millones de parámetros sin sacrificar eficiencia.

Por ejemplo, en tareas como analizar una base de código completa o un documento jurídico extenso, DeepSeek V3.2-Exp puede activar solo los expertos relevantes, reduciendo el consumo de recursos mientras mantiene un alto nivel de precisión. Esta capacidad no solo optimiza el rendimiento, sino que también democratiza el acceso a la IA al hacerla más asequible para empresas y desarrolladores.

Código abierto y accesibilidad: Un desafío a los gigantes de la IA

Además de su innovación técnica, DeepSeek destaca por su estrategia de código abierto y una reducción del 50% en los precios de su API. Esta combinación representa un desafío directo a las grandes tecnológicas occidentales, que suelen optar por modelos cerrados. Al liberar sus modelos, DeepSeek no solo fomenta la colaboración global, sino que también acelera la innovación al permitir que desarrolladores de todo el mundo experimenten con su tecnología.

Esta apertura tiene implicaciones profundas. Por un lado, reduce las barreras de entrada para startups y pequeñas empresas que desean integrar IA en sus productos. Por otro, plantea una pregunta crítica sobre la democratización de la IA: ¿debería esta tecnología estar controlada por un puñado de gigantes o ser accesible para todos? DeepSeek parece apostar por lo segundo, lo que añade una dimensión geopolítica fascinante al debate.

Aplicaciones prácticas de DeepSeek V3.2-Exp

La capacidad de DeepSeek V3.2-Exp para manejar contextos largos abre un abanico de posibilidades en diversos campos:

- Desarrollo de software: Los desarrolladores pueden analizar y razonar sobre bases de código completas, identificando errores o generando documentación automáticamente.

- Sector legal: Los profesionales pueden procesar contratos o normativas extensas, extrayendo información relevante con mayor rapidez y precisión.

- Creación de contenido: Los escritores pueden generar narrativas coherentes basadas en prompts extensos, como resúmenes de libros o guiones complejos.

- Investigación científica: Los investigadores pueden analizar grandes volúmenes de datos, como artículos académicos o bases de datos, para identificar patrones o generar hipótesis.

Estas aplicaciones no solo son posibles gracias a la eficiencia de la atención dispersa, sino también a la accesibilidad del modelo, que permite a más personas y organizaciones aprovechar estas capacidades.

El impacto geopolítico y la paradoja de la innovación

El lanzamiento de DeepSeek V3.2-Exp no solo es un avance técnico, sino también un hito en la carrera global por la supremacía en IA. Mientras que las empresas occidentales han dominado el discurso con sus modelos masivos, la innovación de DeepSeek demuestra que la eficiencia y la inteligencia arquitectónica pueden ser igual de poderosas. Sin embargo, surge una paradoja: el origen chino de DeepSeek podría generar reticencias en algunos mercados occidentales, a pesar de la calidad de su tecnología. Si este modelo hubiera sido desarrollado en Silicon Valley, es probable que ya estuviera siendo adoptado masivamente.

Esta situación plantea una reflexión sobre cómo la geopolítica influye en la adopción de la tecnología. En un mundo ideal, la calidad y la innovación serían los únicos criterios, pero la realidad es más compleja. DeepSeek, con su enfoque en código abierto y accesibilidad, invita a reconsiderar estas dinámicas y a apostar por un futuro donde la IA sea una herramienta global, no un monopolio.

Hacia una IA más inteligente y accesible

DeepSeek V3.2-Exp marca un antes y un después en el desarrollo de la inteligencia artificial. Su mecanismo de atención dispersa y su arquitectura Mixture of Experts no solo resuelven problemas de eficiencia, sino que también amplían los límites de lo que la IA puede lograr. Al combinar estas innovaciones con una estrategia de código abierto y precios competitivos, DeepSeek no solo desafía a los gigantes de la industria, sino que redefine el futuro de la IA como una tecnología más inclusiva y sostenible.

La lección más importante de DeepSeek es que el progreso en IA no se trata solo de construir modelos más grandes, sino de diseñar arquitecturas más inteligentes. Este enfoque abre un horizonte de posibilidades, desde aplicaciones prácticas hasta un replanteamiento de cómo concebimos el poder computacional. Mientras el mundo observa, DeepSeek V3.2-Exp nos recuerda que la próxima frontera de la IA no está en la fuerza bruta, sino en la creatividad y la eficiencia.